Đầu tháng 8, Apple công bố kế hoạch phát triển phiên bản mới của hệ thống nhận dạng tài liệu trẻ em bị lạm dụng tình dục (Child Sexual Abuse Material - CSAM). Song, thông báo này đã tạo ra làn sóng lo ngại và tranh cãi về quyền riêng tư của người dùng.

Apple tuyên bố không tuân theo yêu cầu của bất kỳ chính phủ nào về việc khai thác CSAM cho mục đích riêng

Nhiều quốc gia bày tỏ quan điểm không đồng tình trước quyết định mới từ Apple. Quốc hội Đức mới đây đã yêu cầu Táo khuyết xem xét lại các kế hoạch phát triển CSAM của mình trong một bức thư gửi đến Tim Cook.

Theo báo cáo của Heise Online, Chủ tịch Ủy ban Chương trình Kỹ thuật số Digital Agenda, Manuel Hoferlin cho rằng Apple đang có nước đi nguy hiểm khi phá vỡ “giao tiếp an toàn và bảo mật”. Mặc dù CSAM chỉ khả dụng ở Mỹ khi ra mắt, Hofelin tin rằng đây sẽ là “công cụ giám sát lớn nhất từ trước đây nay” và có thể khiến Apple mất quyền tiếp cận các thị trường lớn dù công ty có tiếp tục chiến dịch này hay không.

Hay tại Mỹ, một liên minh quốc tế về chính sách cùng các nhóm vận động dân quyền đã công bố bức thư gửi Apple, yêu cầu nhà sản xuất “từ bỏ những kế hoạch xây dựng tính năng giám sát nội dung trên iPhone, iPad và các dịch vụ trong hệ sinh thái của Apple”.

“Mặc dù những tính năng này nhằm mục đích bảo vệ trẻ em và giảm sự phát tán các hình ảnh, dữ liệu có liên quan đến việc lạm dụng trẻ, chúng tôi lo ngại nó sẽ được dùng vào những mục đích bất lợi cho người dùng, đe dọa quyền riêng tư cũng như an ninh bảo mật của mọi người trên khắp thế giới”, bức thư nêu rõ.

Ngoài CSAM, Apple còn triển khai một công cụ có thể quét ảnh gửi trong iMessages, sử dụng máy học để xác định và làm mờ các hình ảnh khiêu dâm mà trẻ em nhận được. Phụ huynh của trẻ dưới 12 tuổi có thể nhận được thông báo nếu trẻ xem hoặc gửi đi những tài liệu như vậy.

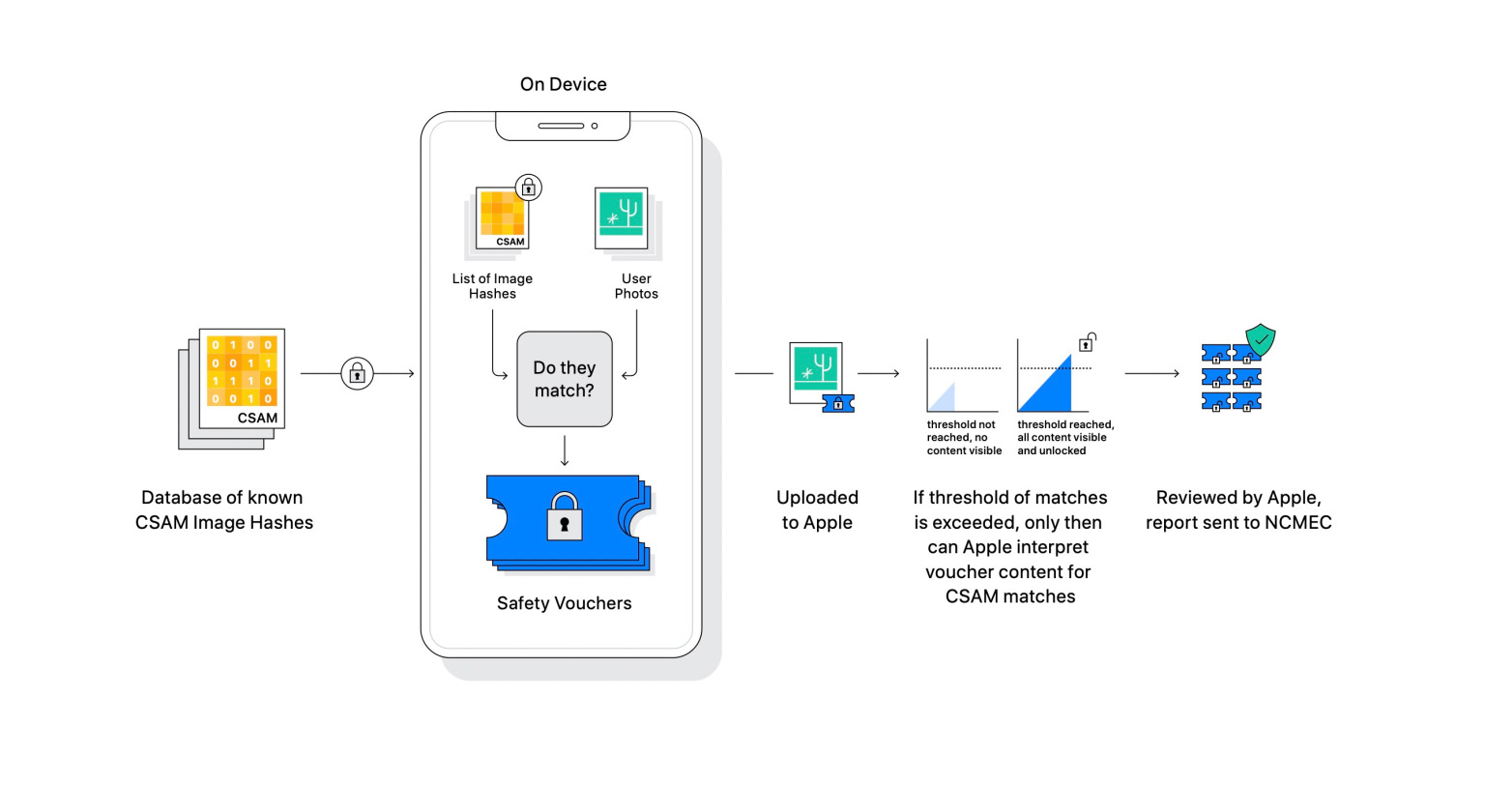

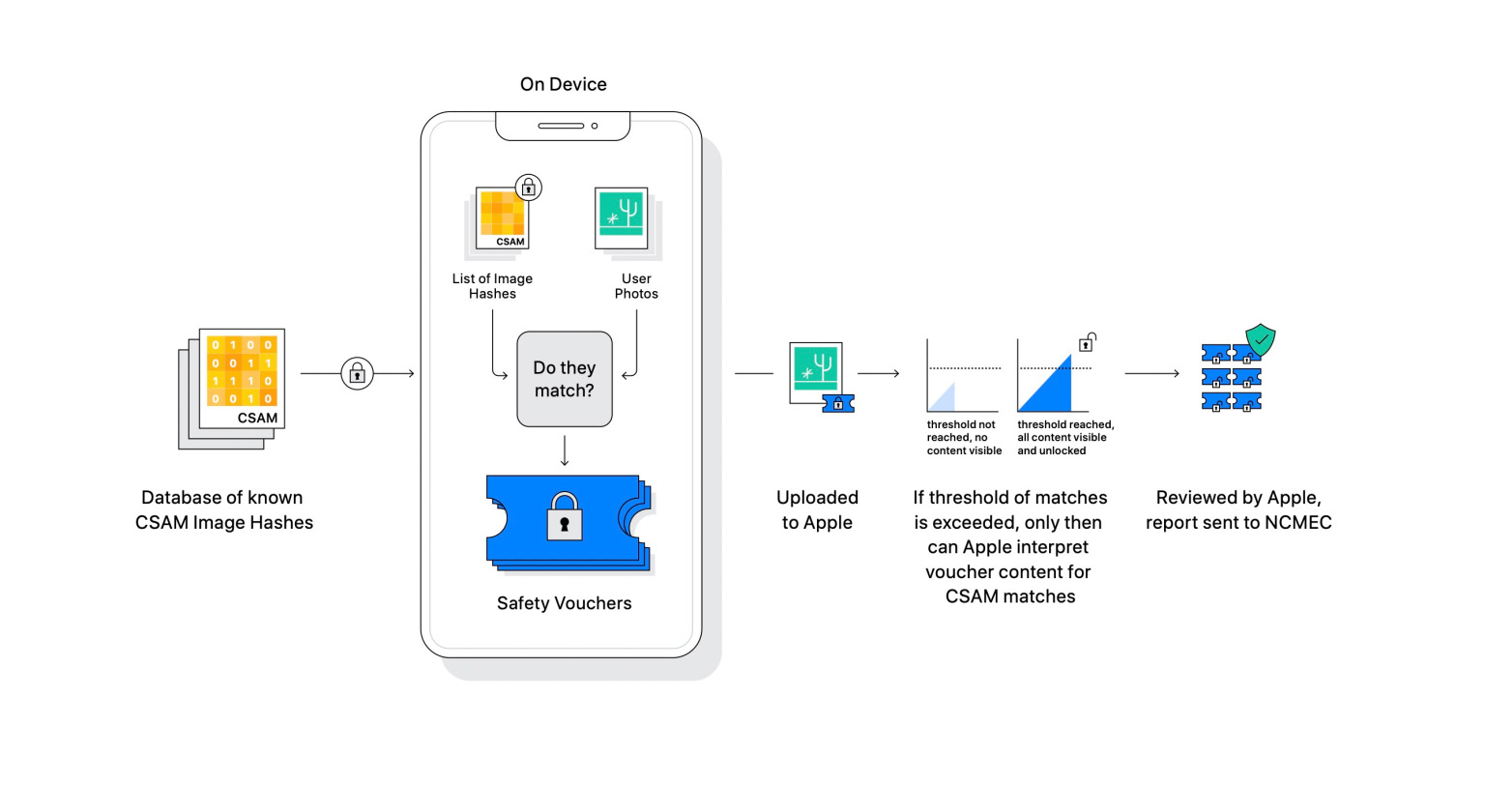

Apple trình bày cơ chế hoạt động của CSAM

Về phần mình, Apple đã cố gắng giải thích rằng quá trình truy quét CSAM không phân tích ảnh của người dùng trên thiết bị iPhone của họ. Táo khuyết sẽ để cho các bên thứ ba thực hiện kiểm toán hệ thống để bảo đảm tính minh bạch mà vẫn đảm bảo tính bảo mật.

Apple cho biết CSAM sẽ chỉ hoạt động đối với ảnh được tải lên iCloud, không bao gồm video. Người dùng không sử dụng tính năng sao lưu hình ảnh trên iCloud cũng đồng nghĩa với việc không tham gia chương trình theo dõi CSAM.

Apple còn tự tin tuyên bố công cụ trên thiết bị của mình tốt hơn nhiều so với phương thức triển khai từ máy chủ mà các ứng dụng khác sử dụng. Hãng cho rằng các ứng dụng khác yêu cầu đơn vị quản lý thực hiện truy quét từng bức ảnh được người dùng lưu trữ trên máy chủ của họ, trong khi CSAM thực hiện quá trình kiểm duyệt rồi mới tải ảnh lên iCloud.

Phần lớn làn sóng phản đối chống lại các biện pháp mới tập trung vào tính năng quét dữ liệu thiết bị. Các nhóm kêu gọi quyền riêng tư cho rằng kế hoạch làm mờ ảnh khỏa thân trong iMessages của trẻ có thể khiến chúng gặp nguy hiểm và làm phá vỡ mã hóa đầu cuối của ứng dụng.

“Chúng tôi biết một số người sẽ hiểu lầm và quan ngại, nhưng chúng tôi sẽ tiếp tục giải thích rõ các chức năng này để mọi người hiểu được nỗ lực của chúng tôi”, Nikkei dẫn lời phát ngôn viên của Apple.

Apple tuyên bố không tuân theo yêu cầu của bất kỳ chính phủ nào về việc khai thác CSAM cho mục đích riêng

Nhiều quốc gia bày tỏ quan điểm không đồng tình trước quyết định mới từ Apple. Quốc hội Đức mới đây đã yêu cầu Táo khuyết xem xét lại các kế hoạch phát triển CSAM của mình trong một bức thư gửi đến Tim Cook.

Theo báo cáo của Heise Online, Chủ tịch Ủy ban Chương trình Kỹ thuật số Digital Agenda, Manuel Hoferlin cho rằng Apple đang có nước đi nguy hiểm khi phá vỡ “giao tiếp an toàn và bảo mật”. Mặc dù CSAM chỉ khả dụng ở Mỹ khi ra mắt, Hofelin tin rằng đây sẽ là “công cụ giám sát lớn nhất từ trước đây nay” và có thể khiến Apple mất quyền tiếp cận các thị trường lớn dù công ty có tiếp tục chiến dịch này hay không.

Hay tại Mỹ, một liên minh quốc tế về chính sách cùng các nhóm vận động dân quyền đã công bố bức thư gửi Apple, yêu cầu nhà sản xuất “từ bỏ những kế hoạch xây dựng tính năng giám sát nội dung trên iPhone, iPad và các dịch vụ trong hệ sinh thái của Apple”.

“Mặc dù những tính năng này nhằm mục đích bảo vệ trẻ em và giảm sự phát tán các hình ảnh, dữ liệu có liên quan đến việc lạm dụng trẻ, chúng tôi lo ngại nó sẽ được dùng vào những mục đích bất lợi cho người dùng, đe dọa quyền riêng tư cũng như an ninh bảo mật của mọi người trên khắp thế giới”, bức thư nêu rõ.

Ngoài CSAM, Apple còn triển khai một công cụ có thể quét ảnh gửi trong iMessages, sử dụng máy học để xác định và làm mờ các hình ảnh khiêu dâm mà trẻ em nhận được. Phụ huynh của trẻ dưới 12 tuổi có thể nhận được thông báo nếu trẻ xem hoặc gửi đi những tài liệu như vậy.

Apple trình bày cơ chế hoạt động của CSAM

Về phần mình, Apple đã cố gắng giải thích rằng quá trình truy quét CSAM không phân tích ảnh của người dùng trên thiết bị iPhone của họ. Táo khuyết sẽ để cho các bên thứ ba thực hiện kiểm toán hệ thống để bảo đảm tính minh bạch mà vẫn đảm bảo tính bảo mật.

Apple cho biết CSAM sẽ chỉ hoạt động đối với ảnh được tải lên iCloud, không bao gồm video. Người dùng không sử dụng tính năng sao lưu hình ảnh trên iCloud cũng đồng nghĩa với việc không tham gia chương trình theo dõi CSAM.

Apple còn tự tin tuyên bố công cụ trên thiết bị của mình tốt hơn nhiều so với phương thức triển khai từ máy chủ mà các ứng dụng khác sử dụng. Hãng cho rằng các ứng dụng khác yêu cầu đơn vị quản lý thực hiện truy quét từng bức ảnh được người dùng lưu trữ trên máy chủ của họ, trong khi CSAM thực hiện quá trình kiểm duyệt rồi mới tải ảnh lên iCloud.

Phần lớn làn sóng phản đối chống lại các biện pháp mới tập trung vào tính năng quét dữ liệu thiết bị. Các nhóm kêu gọi quyền riêng tư cho rằng kế hoạch làm mờ ảnh khỏa thân trong iMessages của trẻ có thể khiến chúng gặp nguy hiểm và làm phá vỡ mã hóa đầu cuối của ứng dụng.

“Chúng tôi biết một số người sẽ hiểu lầm và quan ngại, nhưng chúng tôi sẽ tiếp tục giải thích rõ các chức năng này để mọi người hiểu được nỗ lực của chúng tôi”, Nikkei dẫn lời phát ngôn viên của Apple.

Theo VN review